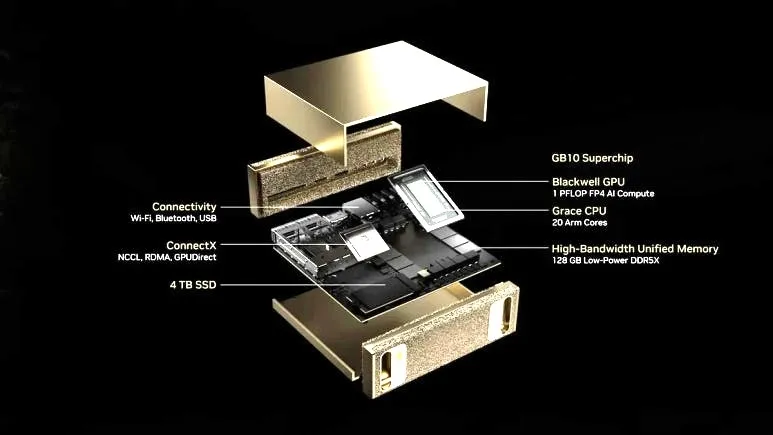

현재 인공지능(AI) 투자 붐으로 인해 그래픽처리장치(GPU)뿐만 아니라 여러 관련 제품의 수요가 폭발적으로 증가하고 있습니다. 그 대표적인 제품이 바로 메모리입니다. 특히 차세대 고대역폭 메모리인 HBM(High Bandwidth Memory)의 수요 급증은 국내 메모리 제조사의 실적은 물론 국내 주식시장 전체를 견인하고 있습니다.

HBM의 가장 큰 장점은 메모리 대역폭이 매우 넓어 GPU의 AI 연산에 필요한 방대한 데이터를 빠르게 처리할 수 있다는 것입니다. 다만, 가격이 매우 비싸 고성능 데이터센터 GPU에만 주로 사용되고 있습니다. 구체적인 가격은 제조사 간의 계약으로 공개되지 않으나, 12단 HBM4 메모리 같은 차세대 제품은 개당 500~600달러 선이라는 루머가 있을 정도입니다.

이러한 가격적 이유로 게임용 그래픽 카드는 여전히 GDDR7 메모리를 사용하고 있습니다. GDDR7은 HBM보다 대역폭은 낮지만 가격이 상대적으로 저렴하여 일반 소비자에게 적합합니다. 다만 서버 GPU 대비 대역폭뿐만 아니라 메모리 용량도 부족하여 거대한 AI 모델을 구동하기 어렵다는 제한점이 있습니다.

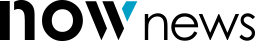

엔비디아가 올해 초 깜짝 공개했던 ‘프로젝트 디짓’은 이러한 약점을 극복하기 위해 등장했습니다. 이 개인용 AI 미니 PC는 연산 능력은 크게 늘리지 않으면서도 메모리 용량을 128GB로 대폭 확장했습니다. 가격을 3000달러 선으로 유지하면서 고용량 메모리를 구현할 수 있었던 비결은 HBM은 물론 GDDR7보다 저렴하고 저전력인 LPDDR5x 메모리를 탑재했기 때문입니다.

엔비디아가 LPDDR5x 메모리를 사용한 AI 칩을 선보인 뒤, 최근에는 인텔과 퀄컴도 이 대열에 합류할 것임을 발표했습니다. 다만 엔비디아와는 달리 이들은 서버 AI 제품군에 LPDDR5x 메모리를 적용할 계획입니다. 내년 하반기 출시를 목표로 하는 인텔의 AI 추론 칩인 크레센트 아일랜드(Crescent Island)는 정확한 속도와 대역폭은 밝히지 않았으나, 160GB의 LPDDR5x 메모리를 사용합니다. Xe3P 아키텍처를 적용한 AI 프로세서로, 정확한 연산 능력 역시 아직 베일에 가려 있습니다. HBM이나 GDDR7이 아닌 스마트폰에 주로 사용되는 LPDDR5x를 채택한 만큼, 가격은 저렴할 것으로 보이며, 인텔은 아마도 보급형 틈새시장을 노릴 가능성이 높습니다.

퀄컴은 이보다 더 본격적으로 엔비디아의 아성에 도전하려는 모습입니다. 최근 공개한 퀄컴 AI200 및 AI250은 엔비디아의 GB300 NVL72처럼 수냉식 서버 랙 시스템을 전제로 하고 있기 때문입니다. 퀄컴 AI200/AI250은 구체적인 대역폭은 미공개 상태이지만, 최대 768GB의 LPDDR5x 메모리를 사용한다고 밝혔습니다. AI 가속기는 퀄컴의 헥사곤 NPU 기반입니다.

AI200/AI250 제품군의 메모리 대역폭이나 연산 능력 모두 미공개 상태이지만, 퀄컴은 LPDDR5x 메모리 기술에 상당한 노하우를 보유하고 있습니다. 예를 들어, 최근 공개한 윈도우 노트북용 프로세서인 스냅드래곤 엘리트 X2 익스트림 프로세서에서 LPDDR5x-9523 16GB 메모리 모듈 3개를 활용하여 192비트 인터페이스로 228GB/s라는 상당한 대역폭을 확보하는 데 성공했습니다.

다만, 아무리 여러 개의 LPDDR5x 메모리를 병렬로 연결해도 HBM 계열처럼 광대한 대역폭을 확보하기는 어렵습니다. 따라서 엔비디아의 GB300 블랙웰 같은 초고성능 AI GPU보다는, 성능은 낮지만 훨씬 저렴하고 전력 소모가 적은 AI 가속기를 여러 개 병렬로 연결하는 전략을 사용할 것으로 보입니다. 참고로 퀄컴 AI200/AI250 랙 시스템 한 개의 전력 소모량은 160kW로 결코 적지 않은 수준입니다.

LPDDR5x 메모리는 저렴하고 전력 소모가 적어 개인용 AI PC 같은 틈새시장을 노리는 엔비디아 DGX 스파크에는 최적의 선택입니다. 하지만 이 분야의 후발 주자인 인텔이나 퀄컴이 데이터센터 시장을 노리고 LPDDR5x 메모리를 채택한 배경에는 다른 이유가 있어 보입니다. 가장 큰 이유는 가격과 수급 문제일 가능성이 높습니다.

인텔과 퀄컴은 업계를 주도하는 대기업이지만, AI 가속기 부문에서는 후발주자인 만큼 현시점에서 시장을 주도하는 엔비디아의 AI GPU와 정면 대결하기는 어렵습니다. 따라서 저전력 또는 저렴한 가격으로 승부수를 던지는 것이 가장 합리적인 접근법이 될 수 있습니다. 여기에 HBM 메모리의 경우 수요 폭발로 인해 가격이 비싸고 수급도 쉽지 않은 상황이므로, 무리하게 HBM을 고집할 필요가 없다는 계산이 깔린 것으로 보입니다. 이러한 접근법이 내년에 가시적인 성과를 거둘 수 있을지 그 결과가 주목됩니다.

고든 정 과학 칼럼니스트 jjy0501@naver.com

Copyright ⓒ 서울신문 All rights reserved. 무단 전재-재배포, AI 학습 및 활용 금지